文章信息

- 方天红, 陈庆虎, 廖海斌, 邱益鸣

- FANG Tianhong, CHEN Qinghu, LIAO Haibin, QIU Yiming

- 融合纹理与形状的人脸加权新特征

- Face Feature Weighted by Fusing Texture and Shape

- 武汉大学学报·信息科学版, 2015, 40(3): 321-326

- Geomatics and Information Science of Wuhan University, 2015, 40(3): 321-326

- http://dx.doi.org/10.13203/j.whugis20130585

-

文章历史

- 收稿日期:2013-10-17

2. 湖北工程学院物理与电子信息工程学院, 湖北 孝感, 432000;

3. 湖北科技学院计算机科学与技术学院, 湖北 咸宁, 437100

2. School of Physics and Electronic-information Engineering, Hubei Engineering University, Xiaogan 432000, China;

3. School of Computer Science and Technology, Hubei University of Science and Technology, Xianning 437100, China

人脸识别是当今模式识别和机器视觉领域的研究热点之一[1, 2, 3]。与指纹、虹膜等其他人体生物特征相比,人脸特征具有便捷性、直接性、唯一性等优点,可以被广泛用于国防安全、商业保密、人机交互、可视通信等众多领域。

人脸特征提取是人脸识别的关键环节和难点。“丑小鸭”定理表明,不存在与问题无关的“优越”的特征提取方法[1]。目前,大部分研究者都集中在研究怎样对原始高维特征空间进行降维与选择上,即在优化某种准则的基础上求出高维模式的低维特征,以用于后续的分类。很少有对原始特征进行优化和预处理的研究,实际上,如果原始特征本身就不具有可分性的话,后面即使使用再好的准则也不可能提取出有效的分类特征。因此,有必要对人脸原始特征进行优化和预处理的研究,为后续的特征提取和识别打好基础。

人脸原始特征可以分为以下两大类:① 几何形状特征;② 纹理特征。Bledsoe通过人工标定人脸特征点,用特征点间距、比率等参数描述人脸,建成了一个半自动的人脸识别系统[2]。后来很多学者对这一方法进行了拓展[3, 4]。这些方法主要是通过精确测量人脸器官及器官之间的几何特征,并用这些几何特征来描述人脸模式,但实际应用中人脸几何特征的提取对光照、视角和表情等变化非常敏感,很难做到精确提取。因此,如何鲁棒地、精确地检测和定位人脸器官是该类方法的关键。近年来,学者们已提出了许多脸部器官定位方法[5, 6]。基于几何结构特征的人脸识别方法优点是物理意义明确,可以实现对人脸显著特征的一个高效描述;但特征点的提取和定位困难,稳定性较差,并且只描述了人脸部件的基本形状与结构关系。目前,大部分几何形状特征使用的是三维几何结构特征[7, 8]。与二维人脸图像相比,三维人脸数据包含了人脸空间结构信息,是人脸固有的本质属性,而且对外界条件变化有很好的鲁棒性。但是,三维人脸识别的实现也有很大的挑战,如三维识别对识别大小比较敏感,存在海量存储和计算量大的问题以及三维数据的获取问题。纹理特征是目前的主流特征,大多数经典的人脸识别方法都是基于纹理特征,包括线性子空间分析方法[9]、非线性核方法[10]、流形学习方法[11]等。其中,主成份分析(PCA)和线性判别分析(LDA)是两种经典的子空间分析方法,被广泛应用于模式识别与计算机视觉领域。

综上所述,人脸的几何形状特征和纹理特征各具特色。Chang等人[12]提出了一种二维与三维人脸相结合的人脸识别方法。该方法将PCA算法分别应用到人脸二维亮度图像和三维深度图像上,进行特征降维、提取、表示与识别;然后,融合两种策略的结果得到整个多模型人脸识别系统的识别结果。Papatheodorou等[13]提出了一种基于四维数据(三维空间坐标信息和一维图像亮度信息)的ICP识别方法。四维数据是通过一个立体照相机系统(由3个照相机构成)和一个模式放映机组成的采集设备获取,并利用四维的欧氏距离进行人脸的相似性度量。融合二维三维信息的人脸表征方式对人脸刻画的比较细致、精确,鲁棒性较高,但通常表征方式的数据量较大,算法计算复杂度较高,而且二维、三维人脸特征的融合方式和连接方式也需要深入研究。本文提出了一种基于二维空间的融合人脸纹理和几何形状的新特征。新的融合特征只需简单地提取人脸5个关键点,然后根据每个像素点与关键点之间的距离对纹理特征进行动态加权。

1 人脸加权新特征

根据人类进行人脸识别可知,人脸的眉毛、眼睛、鼻子等器官区域比其他区域更重要和可靠。而且人类往往能根据人脸某一显著器官就能分辨出人脸。文献[14]指出人脸各部位的特征对人脸识别的作用是不一样的,其中眉毛对人脸识别的作用最大。本文根据每个像素点到关键特征点之间的距离,对人脸纹理特征进行重新赋值。首先利用文献[15]方法提取人脸5个关键特征点(左眼中心、右眼中心、鼻尖点、左嘴角和右嘴角)。然后,根据像素点与关键特征点之间的欧氏距离,对纹理图像进行加权计算。新特征的计算为:

式中,Fp为人脸图像在p点处的新特征值;ρ为p点处的灰度值;xi(i=1,2,3,4,5)为关键特征点的坐标;d(p,xi)2为p点与最近的关键点之间的欧氏距离;σ为幅射因子。对d(p,xi)进行归一化为:

式中,m、n为图像的长和宽。式(1)是一个高斯分布,其方差为σ,期望为xi。通过式(1)将原人脸图像转换到5个高斯子空间。高斯分布有两个参数,即期望μ和方差σ。μ是位置参数,σ是形状参数,当μ固定不变时,σ越大,曲线越平阔;μ越小,σ曲线越尖峭。图 1为σ分别取0.05、0.1、0.3的效果图,当σ大于0.3时,变换后的图像 与原图像一样。从式(1)可以看出,p点离xi越近Fp越大,p点离xi越远ρ的权值越小(图 1)。式(1)说明,离关键点(左眼中心、右眼中心、鼻尖点、左嘴角和右嘴角)越近其特征越重要,而脸颊和额头等区域点离关键点较远,其特征点相对不那么重要。这与进行人脸辨别的规律相符。

|

| 图 1 人脸加权新特征示意图 Fig. 1 Sketch Map of Face Weighed |

在人脸5个关键特征点的基础上,将人脸分为5块(左眼区域、右眼区域、鼻子区域、左嘴区域和右嘴区域)。根据高斯分布3σ原则有:在μ周围大约1σ半径内的数据占68.72%,在μ周围大约2σ半径内的数据占95%,在μ周围大约3σ半径内的数据占99%,如图 2所示。根据3σ原则,灵活地提取不同大小的人脸分块特征。

|

| 图 2 高斯分布3σ原则 Fig. 2 Gaussian Distribution 3σ Principle |

图 3显示了分别取1σ和1.5σ时的分块情况,其中1σ表示以关键点为中心,以1σ为半径的人脸块。

|

| 图 3 人脸不同分块情况示意图(σ=0.1) Fig. 3 Sketch Map of Face Block Processing(σ=0.1) |

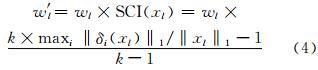

对于正面、中性表情人脸,各分块的权值可以根据文献[14]中的人脸各器官重要性的结论:Eyebrow≥Eye≥Mouth≥Nose,选择权值we、wn、wm。但对于实际应用中有表情和姿态变化的人脸,各分块的权值不是固定不变的,应该根据表情和姿态的变化而变化的。如对于左偏转的图像,其左眼和左嘴区域的纹理特征是不完整的,这时应该降低其权值。因此,必须根据输入人脸不同的情况对权值进行动态地选择。首先求出各分块的稀疏度指数(SCI)[16]:

式中,k为类别数;x是求出稀疏表示系数向量;δi(x)是一个特殊的向量,其中非0项为第i类的非0项,其他项全为0;‖·‖1为向量中非0元素的个数。如果SCI(x)=1,测试图像只由一个训练人脸图像表示,其表征系数很稀疏,说明具有很强的分类性;如果SCI(x)=0,测试图像由所有训练图像表示,其表征系数非常不稀疏,说明不具有分类性[17]。如果某子区域存在姿态或是有较大的表情变化,那么其表征系数必定不稀疏,即它相对应的稀疏度指数值必定很小(接近0)。因此,动态权值为:

通过公开的人脸数据库来验证本文新特征的效果。首先,通过LDA[9]方法和稀疏表示方法(SRC)[16]对本文提出的加权新特征与原始纹理特征进行比较。然后,对本文提出的分块方法进行实验分析,进一步验证本文方法的有效性。

Yale[18]人脸库包括15个人的165幅灰度人脸图像。每个人由11幅照片构成,每人的每幅图像均是从不同的视角获得的,有较大的表情变化、光照变化以及部分缺损(图 4)。实验中,裁剪出样本图像的人脸部分并将大小处理成100像素×100像素的分辨率,分别取每人的前6幅图像进行训练,其余图像用于测试。

|

| 图 4 YALE人脸库示例 Fig. 4 Example of YALE Face Database |

XJTU[19]人脸库由西安交通大学人工智能与机器人研究所创建,包括人脸视点和光照两个子库,共采集并整理了1 247位志愿者的33 669幅人脸图像。其中,每位志愿者拍摄19张视点图像和8张光照图像(图 5)。从XJTU人脸库中随机抽取100个作为人脸识别的数据库,每个人从视点数据间隔取10张不同姿态的图像作为人脸样本数据库(图 6),取其中2、4、6、9作为测试人脸,剩下的6幅作为训练人脸。这样测试人脸与训练人脸角度最小相差18°,最大相差144°。

|

| 图 5 XJTU人脸库示例 Fig. 5 Example of XJTU Face Database |

|

| 图 6 从XJTU姿态人脸库中间隔选取的人脸 Fig. 6 Interval Selected from the XJTU Pose Database |

分别采用LDA方法和SRC方法在YALE人脸库和XJTU人脸库验证新的加权特征的有效性。图 7(a)显示了LDA方法中σ取不同值的识别率情况,从图中可以看出,在YALE人脸库中,随着σ值的增加识别率有所提高,到σ=0.2时新的加权特征的识别率到达最高,随后识别率有所下降,到达0.5以后,识别率保持在原特征的识别率不变。同样地,从图 7(b)可以看出,当σ为0.05时,SRC方法的识别率最高,到达0.5以后识别率保持在原特征的识别率不变。这是由高斯分布的性质决定的,因为高斯分布的形状由方差σ决定,而形状的平与尖决定了原特征权值的大小。图 8显示了原图像在σ分别取0.05、0.1、0.2和0.5时新图像分布图。从图 8可以看出,当σ太小时,损失了太多的信息,当σ超过0.5时,新图像和原图像保持不变,此时新的加权特征等价于原特征。因此,LDA方法的最佳σ=0.2,SRC 方法的最佳σ=0.05。表 1给出了新的加权特征与原特征的比较结果。从表 1中可以看出,对于YALE人脸库,新特征比原特征提高1%的识别率,对于XJTU人脸库,新特征比原特征提高7%左右的识别率;同时,SRC方法比LDA方法具有更好识别率。说明新特征对具有姿态变化的人脸更具鲁棒性。虽然提高的幅度不是很大,但这种特征加权的方法为原始特征的预处 理提供一个研究方向。

|

| 图 7 σ取不同值时的识别率情况 Fig. 7 Recogniton Rate from Different σ |

|

| 图 8 σ取不同值时的人脸新特征示意图 Fig. 8 New Facial Feature by Different σ |

| YALE/% | XJTU/% | |

| 原始特征 | 92.22/ 92.22 | 57.5/73.5 |

| 新特征 | 93.33/93.33 | 65/78.7 |

由实验分析可知,新特征比原特征更具分类性,尤其是对姿态变化的情况。但新特征识别率的提高是以定位5个关键点为基础的,我们提取出5个关键点后,识别率也才提高约5%,似乎有点得不偿失。其实不然,如果经过对原始纹理特征进行加权处理后,对所有方法其识别率都能提高约5%,其实也是非常有价值的。其次,提取出的5个关键点会非常方便地进行人脸分块识别。

特征加权的人脸分块识别方法如下。

1) 根据提取的5个关键点将人脸分为5部分(左眼部分、右眼部分、鼻子部分、左嘴部分和右嘴部分)。

2) 采用§2.2的方法对各分块动态选取权值。

3) 融合各部分得出分类结果。采用人脸分块以后,用于识别的特征急剧减少,为了保留更多的特征,这里将方差相应地取大些(相对整体方法):LDA方法σ=0.5,SRC方法σ=0.1。

图 9显示了在YALE和XJTU人脸库上,分块取不同半径区间的识别率情况,从图 9中可以看出,对于YALE人脸库取2σ取得最好识别率,对于XJTU人脸库取1.5σ取得最好识别率。图 10展示了不同半径区间的人脸分块的情况,图 中红圈内白色区域是需要插值的部分。从图 10 可以看出,区间取得太小,损失过多信息;取得太大,需要插值区域太多。因此,需要折衷考虑半径区间范围。由于XJTU人脸库存在姿态变化,因此,其区间范围比YALE人脸库要小。表 2为采用LDA法和SRC法分别在YALE人脸库和XJTU人脸库进行实验比较的结果,从表 2可以看出,采用本文提出的人脸分块和加权新特征的方法,识别率接近100%,比原特征相比提高约40%。

|

| 图 9 不同半径区间的识别率 Fig. 9 Recognition Rate of Different Radius of Interval |

|

| Fig. 9 Recognition Rate of Different Radius of Interval Fig. 10 Interval Change Based on YALE and XJTU Database |

| YALE/% | XJTU/% | |

| 原始特征 | 92.22/92.22 | 57.5/73.5 |

| 新特征 | 93.33/93.33 | 65/78.7 |

| 新特征+分块 | 100/100 | 97.5/97.5 |

本文利用人类进行人脸识别的特点,根据人脸各像素到关键特征点的距离对人脸原特征进行动态加权处理,使新特征融合了人脸纹理和关键点形状特征。通过本文方法对原始特征进行预处理后,新特征更具鉴别性和抗干扰性,为原特征的预处理提供了一个研究方向。同时,本文提出基于关键点的人脸分块识别方法,在权值选择时根据各分块的稀疏度进行动态权值选择。最后识别率说明本方法的有效性和对姿态变化的鲁棒性。

| [1] | Watanabe S .Pattern Recognition:Human and Mechanical[M].New York:Wiley Press, 1985 |

| [2] | Beldeso W W. Man-Machine Facial Recognition[R].Panoramic Res Inc, Palo Alto, Rep PRI, CA, 1966 |

| [3] | Jia X, Nixson M S. Extending the Feature Vector for Automatic Face Recognition[J].IEEE Trans on Pattern Analysis and Machine Intelligence(PAMI), 1995, 17(12):1 167-1 176 |

| [4] | Lam K M, Yan H. An Analytic-to-holistic Approach for Face Recognition Based on a Single Frontal View[J].IEEE Trans on PAMI, 1998, 20(7):673-686 |

| [5] | Cootes T, Eewards G, Taylor C. Active Appearance Models[C]. Proceeding of ECCV98, Freiburg, Germany, 1998 |

| [6] | Hamouz M, Kittler J, Kamarainen J K, et al. Feature-based Affine-invariant Localization of Face[J].IEEE Trans on PAMI, 2005, 27(9):1 490-1 495 |

| [7] | Scheenstra A, Ruifrok A, Veltkamp R C. A Survey of 3D Face Recognition Methods [C]. Proceedings of International Conference on Audio and Video-Based Biometric Person Authentication, New York, 2005 |

| [8] | Bowyer K, Chang K, Flynn P. A Survey of Approaches and Challenges in 3D and Multi-modal 3D+2D Face Recognition[J].Computer Vision and Image Understanding, 2006, 101(1):1-15 |

| [9] | Belhumeur P N, Hespanha J P, Kriengman D J. Eigenfaces Versus Fisherfaces:Recognition Using Class Specific Linear Projection[J].IEEE Trans on PAMI, 1997, 19(7):711-720 |

| [10] | Ozertem U, Erdogmus D, Jessen R. Spectral Feature Projections that Maximize Shannon Mutual Information with Class Labels[J].Pattern Recognition, 2006, 39(7):1 241-1 252 |

| [11] | He X F, Niyogi P. Locality Preserving Projections[C].Advances in Neural Information Processing System 16, Vancouver, Canada, 2003 |

| [12] | Chang K, Bowyer K, Flynn P. Face Recognition Using 2D and 3D Facial Data[C].ACM Workshop on Multimodal User Authentication, Santa Barbara, CA, 2003 |

| [13] | Papatheodorou T, Rueckert D. Evaluation of Automatic 4D Face Recognition Using Surface and Texture Registration[C]. IEEE International Conference on Automatic Face and Gesture Recognition, Seoul, Korea, 2004 |

| [14] | Sinha P, Balas B, Ostrovsky Y, et al. Face Recognition by Humans:Nineteen Results all Computer Vision Researchers Should Know About[J].IEEE, 2006, 11(94):1 948-1 962 |

| [15] | Liang L, Xiao R, Wen F, et al. Face Alignment via Component-based Discriminative Search [C]. ECCV, Marseille, France, CA, 2008 |

| [16] | Liao Haibin, Chen Qinghu, Wang Hongyong. Robust Face Recognition by Fusion Local Deformable Model[J].Geomatics and Information Science of Wuhan University, 2011, 36(7):877-879(廖海斌, 陈庆虎, 王宏勇. 融合局部形变模型的鲁棒性人脸识别[J].武汉大学学报\5信息科学版, 2011, 36(7):877-879) |

| [17] | Wright J, Yang Allen Y, Ganesh A. Robust Face Recognition via Sparse Representation[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2009, 31(2):210-227 |

| [18] | Cootes T F, Edwards G J, Taylor C J. Active Appearance Models[J].IEEE Trans on PAMI, 2001, 23(6):681-685 |

| [19] | AI & R Institute of Artificial Intelligence and Robotics Xi'an Jiaotong University. Oriental Face Database[OL]. http://www.aiar.xjtu.edu.cn/groups/face/Chinese/Homepage.html, 2013 |

2015, Vol. 40

2015, Vol. 40