文章信息

- 赵望宇, 李必军, 单云霄, 徐豪达

- ZHAO Wangyu, LI Bijun, SHAN Yunxiao, XU Haoda

- 融合毫米波雷达与单目视觉的前车检测与跟踪

- Vehicle Detection and Tracking Based on Fusion of Millimeter Wave Radar and Monocular Vision

- 武汉大学学报·信息科学版, 2019, 44(12): 1832-1840

- Geomatics and Information Science of Wuhan University, 2019, 44(12): 1832-1840

- http://dx.doi.org/10.13203/j.whugis20180146

-

文章历史

收稿日期: 2018-08-08

2. 中山大学数据科学与计算机学院, 广东 广州, 510275

2. School of Data and Computer Science, SUN YAT-SEN University, Guangzhou 510275, China

城市复杂条件下的交通环境感知是智能车辆实现高级驾驶辅助与自动驾驶的先决基础。而车辆作为交通环境的重要载体,有效实现前方车辆检测与稳定跟踪是实现智能车辆交通环境感知的关键部分。

视觉传感器具有成本低、采集数据信息量丰富、易于目标识别分类等优点,广泛应用于前方车辆检测[1]。基于视觉传感器的车辆检测可以分为基于单目视觉和基于双目(多目)视觉的车辆检测。其中基于单目视觉的车辆检测可分为检测与识别两个过程[2]。首先通过初始检测来获得假设目标,利用车辆特征(车底阴影[3]、边缘对称性[4]等)和图像运动(帧差法[5]、光流法[6]等)来形成假设的目标区域,然后通过基于模板[7]与基于机器学习[8-9]的方法对假设进行核定,去除所有非车辆区域,进一步对前方车辆进行定位。基于视觉的检测方法易受环境(天气、光照等)影响,且无法获取目标的准确运动信息。

毫米波雷达使用30~300 GHz频域的电磁波,穿透烟、尘等能力强,具有良好的环境适应性,可探测障碍物相对雷达的距离、速度等信息,是目前智能车辆广泛采用的传感器之一[10]。受限于其工作原理,毫米波雷达探测噪声较大,杂波数据较多。现有雷达杂波剔除方法主要有阈值法[11]与模型法[12-13],这类方法的参数设置通常不具有普适性与场景自适应性。此外,毫米波雷达无法获取目标的几何信息与类别信息。

基于多传感器融合的车辆检测方法可将雷达与视觉的优势充分结合,通过雷达获取目标位置和运动信息,通过视觉获取目标类别与几何信息,提高对前方车辆的感知能力[14]。现有融合雷达与视觉的前车检测方法[15-17]通过将毫米波雷达探测结果投影至图像并生成兴趣区域(regions of interest,ROI),利用对称性等特征对ROI进行检测,实现前车目标的获取。由于缺乏对雷达噪声的有效处理,并且车辆检测特征单一,现有方法在复杂环境下的鲁棒性较差,误检率较高。

为满足城市复杂交通场景的前车感知需求,本文做出以下改进。在雷达数据处理部分,提出一种基于层次聚类的雷达杂波剔除方法,降低了雷达噪声对系统检测的影响;在视觉数据处理部分,提出一种基于目标景深的自适应车辆检测方法,将车底阴影特征与支持向量机(support vector machines,SVM)分类器相结合,解决了原有方法在恶劣光照条件下失效的问题;在目标检测基础上增加目标跟踪过程,提出一种基于核相关滤波器(kernelized correlation filter,KCF)[18]-扩展卡尔曼滤波(extended Kalman filter, EKF)[19]组合滤波的跟踪方法,增强了检测的稳定性。在不同城市道路环境与天气状况下对算法进行实车验证,结果证明,本文方法较现有方法具有更好的准确性与鲁棒性。

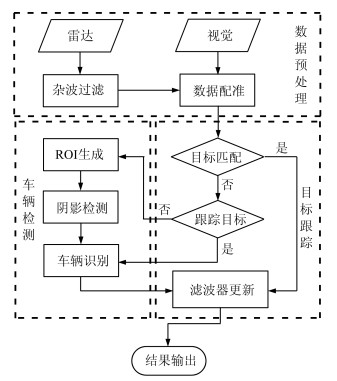

1 算法基本流程设计本文算法分为数据预处理、车辆检测和目标跟踪3个部分,如图 1所示。数据预处理部分首先对毫米波雷达数据进行处理,剔除无效杂波,提取出潜在车辆目标,其次对雷达数据与图像数据进行配准,并将雷达目标投影至图像像素坐标系。车辆检测部分首先基于雷达数据生成车辆存在假设ROI,其次对ROI进行车底阴影检测,排除非车辆目标,并基于车底阴影线对车辆ROI进行重生成,最后采用SVM分类器对ROI进行识别,完成车辆目标的核定。目标跟踪部分采用Trigger机制对车辆目标进行跟踪,首先将跟踪目标与探测目标进行匹配,其次对匹配成功的目标进行更新,对未匹配成功的目标进行存在性检验,最后输出检测结果。

|

| 图 1 算法整体流程图 Fig. 1 Overall Architecture of the Proposed Vehicle Detection and Tracking Approach |

车载毫米波雷达的探测结果均为点目标(θ,ρ,v),包含目标方位角θ、与雷达的相对距离ρ和相对速度v,无目标几何信息。在雷达自身运动状态未知的条件下,无法根据目标原始探测信息对其类型进行判别。本文通过分析大量实测数据,发现在动态交通场景中,毫米波雷达探测结果中仅包含少量动态目标(机动车辆等),其余均为静态背景目标(杂波数据)并且运动状态均相同。为此,本文采用层次聚类算法对雷达目标依其相对速度

聚类后一共可获取k个类簇,其中成员数目最多的类簇为静态目标集合,其余的k-1个类簇为动态目标集合。层次聚类算法环境自适应性强,计算耗时低,在雷达自身运动状态信息未知的情况下能有效实现动态目标与静态目标的划分,消除雷达噪声的影响。

2.2 雷达与视觉空间配准在多传感器系统中,不同传感器对障碍物坐标描述不同。要实现多传感器融合,需要将各传感器数据统一到同一坐标系。车载毫米波雷达与视觉传感器的空间转换模型可表示为:

| ${z_c}\left[ {\begin{array}{*{20}{c}} u\\ v\\ 1 \end{array}} \right] = k\left[ {\begin{array}{*{20}{c}} {\frac{f}{{{d_x}}}}&0&{{u_0}}&0\\ 0&{\frac{f}{{{d_y}}}}&{{v_0}}&0\\ 0&0&1&0 \end{array}} \right]\left[ {\begin{array}{*{20}{l}} \mathit{\boldsymbol{R}}&\mathit{\boldsymbol{T}}\\ {{0^{\rm{T}}}}&\mathit{\boldsymbol{I}} \end{array}} \right]\left[ {\begin{array}{*{20}{c}} {{x_r}}\\ {{y_r}}\\ {{z_r}}\\ 1 \end{array}} \right]$ | (1) |

式中,(xr yr zr 1)T为毫米波雷达坐标系下障碍物的坐标, 其对应像空间坐标系为(xc yc zc 1)T;(u v 1)T为图像像素坐标系下障碍物的坐标;R为3×3的单位正交旋转矩阵;T为3×1的平移矩阵;I为单位矩阵;dx与dy分别表示每个像素在横、纵轴上的物理单位下的大小;f是相机的焦距;k为缩放因子。

本文分别对毫米波雷达与视觉传感器进行空间标定,使雷达平面法向量与相机主光轴同车辆纵向对称平面平行[20],得到旋转矩阵R与平移矩阵T;通过张正友标定法[21]对相机进行内参标定,得到像空间坐标系到像素坐标系的转换矩阵。图 2为数据预处理过程。

|

| 图 2 数据预处理 Fig. 2 Data Preprocessing |

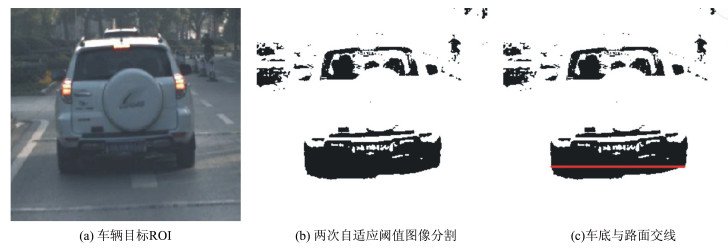

融合雷达与视觉的车辆检测可归纳为假设生成与假设验证两个步骤。首先设定基于雷达目标生成图像车辆存在假设ROI,再通过对ROI进行车辆存在性判别,完成车辆检测。为提高检测的准确性与鲁棒性,本文提出一种基于目标景深的自适应车辆检测方法。首先对车辆假设ROI进行自适应分割;然后结合目标景深信息进行阴影检测,排除显著非车辆目标,同时利用车底阴影线对车辆ROI进行准确重生成;最后利用基于HOG(histogram of oriented gradient)特征的SVM分类器对车辆进行再次检验,确定最终车辆目标。

车底阴影作为一种鲁棒性强的车辆特征,被广泛用于车辆检测,车底阴影分割的效果将直接影响到系统检测的准确性。文献[22]采用图像均值和均方差差值作为分割阈值,能较好地过滤路面噪声干扰不明显的非感兴趣目标。考虑到实际图像可能会受到强光及大面积阴影干扰,仅采用一次阈值分割不能有效抑制干扰,文献[23]提出两次自适应阈值分割,可较好抑制噪声干扰。本文针对图像ROI区域的分割,对自适应阈值进行改进,使分割后的车底阴影更加完整与平滑,进一步提高阴影检测的可靠性。改进公式为:

| $\left\{ {\begin{array}{*{20}{l}} {{T_i} = {\mu _{_i}} - \frac{{{\sigma _i}}}{{{k_i}^2}}, {k_i} = \frac{{{\mu _{_i}}}}{{{\delta _i}}}, i = 1, 2}\\ {{\mu _{_i}} = \sum\limits_{m = 1} ^M \sum\limits_{n = 1} ^N \frac{{f\left( {x + m, y + m} \right)}}{{MN}}}\\ {{\delta _i} = \sqrt {\sum\limits_{m = 1} ^M \sum\limits_{n = 1} ^N \frac{{{{\left[ {f\left( {x + m, y + m} \right) - {\mu _{_i}}} \right]}^2}}}{{MN}}} } \end{array}} \right.$ | (2) |

式中,f(x,y)为灰度图像在(x,y)点处的灰度值;M、N分别为图像的宽和高;μ、δ、T分别为灰度图像均值、均方差与分割阈值。

车底与路面交线能准确定位车辆位置,通过交线长度可实现车辆目标的判别。对于分割后的图像,本文按从下往上、从左往右的顺序搜索阴影线起点与终点。当搜索点符合式(3)时,记为起点xs;继续扫描连续黑点,符合式(4)时,记为终点xe。

| $\left\{ {\begin{array}{*{20}{l}} {f\left( {x - 1, y} \right) - f\left( {x, y} \right) = 255}\\ {f\left( {x, y} \right) - f\left( {x + 1, y} \right) = 0} \end{array}} \right.$ | (3) |

| $\left\{ {\begin{array}{*{20}{l}} {f\left( {x, y} \right) - f\left( {x - 1, y} \right) = 0}\\ {f\left( {x + 1, y} \right) - f\left( {x, y} \right) = 255} \end{array}} \right.$ | (4) |

式中:f(x, y)为像素点(x, y)的灰度值。

由于透视投影关系,不同车距下的车底阴影线像素长度不同。基于目标景深信息,可获取当前车距下目标车辆阴影线实际长度wr对应的理论像素长度wp:

| ${w_p} = \frac{f}{d} \cdot {w_r}$ | (5) |

式中,f为相机焦距;d为目标景深。

将检测结果wd=|xe-xs|与wp进行比较,当连续检测到的k条阴影线均满足下式:

| $\alpha \cdot {w_p} \le {w_d} \le \beta \cdot {w_p}$ | (6) |

则停止搜索,判定目标通过阴影检测,并将阴影线进行合并。本文中取k=3,α=0.8,β=1.2。阴影检测过程如图 3所示。

|

| 图 3 阴影检测 Fig. 3 Vehicle Shadow Detection |

基于HOG特征的SVM分类器是车辆识别中广泛使用的一种方法。HOG是一种图像特征描述子,通过计算和统计图像局部区域的梯度方向直方图来构成特征。车辆图像中,梯度与边缘的方向密度分布可以很好地描述车辆的外观形状,灰度值变化平缓的区域梯度幅值较小,而灰度突变的边缘区域的梯度幅值较大。因此,HOG特征能较好地描述车辆图像。定义像素点(x, y)的梯度幅值和梯度方向计算式为:

| $ \left\{ {\begin{array}{*{20}{l}} {{G_x}\left( {x, y} \right) = H\left( {x + 1, y} \right) - H\left( {x - 1, y} \right)}\\ {{G_y}\left( {x, y} \right) = H\left( {x, y + 1} \right) - H\left( {x, y - 1} \right)}\\ {G\left( {x, y} \right) = \sqrt {\left( {{G_x}{{\left( {x, y} \right)}^2} + {G_y}{{\left( {x, y} \right)}^2}} \right)} }\\ {\alpha \left( {x, y} \right) = {\rm{arctan}}\left( {{G_y}\left( {x, y} \right)/{G_x}\left( {x, y} \right)} \right)} \end{array}} \right. $ | (7) |

式中:Gx(x, y)、Gy(x, y)、H(x, y)分别代表像素点(x, y)的水平方向梯度、垂直方向梯度和像素值。

SVM是建立在统计学习理论的VC维理论和结构风险最小化原则(structural risk minimization, SRM)基础上的新型机器学习方法,在小样本情况下也能取得比较好的分类效果,目前已经广泛应用于车辆、行人检测等分类器的设计中。SVM实质为一个二分类器,通过一个最佳划分样本类别的超平面实现目标分类,其超平面参数求解可转化为一个带约束的二次型优化问题:

| $ \left\{ {\begin{array}{*{20}{l}} {{\mathit{\boldsymbol{w}}^{\rm{T}}}x + b = 0}\\ {\mathit{\boldsymbol{w}}, b = {\rm{argmin}}\frac{1}{2}{\mathit{\boldsymbol{w}}^2}}\\ {\begin{array}{*{20}{c}} {{y_i}\left( {{\mathit{\boldsymbol{w}}^{\rm{T}}}{x_i} + b} \right) \ge 1}&{i = 1, 2 \cdots m} \end{array}} \end{array}} \right. $ | (8) |

式中,w、b为超平面参数;(xi,yi)、(xi,yi)分别表示第i个训练样本的特征与类别。

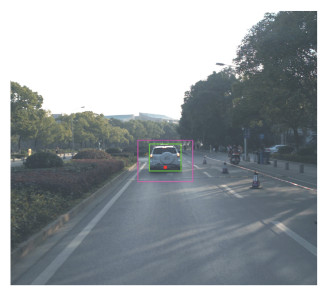

本文采用LibSVM工具箱实现分类器训练与检测,训练样本数目为20 914个,其中正样本5 365个,负样本15 549个,交叉验证精度为94.89%。图 4中,紫色框为基于雷达数据生成的车辆ROI,绿色框为检测输出的车辆ROI。

|

| 图 4 车辆识别 Fig. 4 Vehicle Detection |

目标跟踪是基于目标检测的结果,通过对运动目标的特征进行建模,利用统计学原理,能够对当前检测的目标的状态,如目标位置、运动速度、颜色变化等进行预测和模型的更新。针对雷达与视觉融合系统,本文提出一种KCF-EKF组合滤波的目标跟踪方法。首先,基于动力学模型利用EKF对毫米波雷达目标进行跟踪;其次,基于KCF对图像目标进行跟踪;最后,采用归一化互相关系数对两者跟踪结果进行融合,提高对车辆目标位置、运动状态与几何参数估计的准确性。

KCF是Henriques等在2015年提出的一种鉴别式图像跟踪方法,其在跟踪过程中训练一个目标检测器,使用检测器去检测下一帧预测位置是否为目标,然后再使用新检测结果去更新训练集进而更新目标检测器。该方法通过核函数技巧与快速傅里叶变换有效提升跟踪器的速度与可靠性,其缺陷为目标检测框尺寸固定,无法对纵向运动目标进行有效跟踪。本文采用尺度池技术[24],通过多模板匹配的方式取得目标最佳响应框。

为更好地满足路面车辆的机动特性,本文采用Bicycle动力学模型对车辆目标进行描述,在雷达探测坐标系下,对车辆的运动状态建立模型(xr,yr,v,θ,φ),前车目标与主车之间的相对运动方程为:

| $\left\{ {\begin{array}{*{20}{l}} {{{\dot x}_r} = v{\rm{cos}}\theta , {{\dot y}_r} = v{\rm{sin}}\theta }\\ {\dot \theta = v{\rm{tan}}\left( {\varphi /B} \right)}\\ {\dot v = a, \dot \varphi = b} \end{array}} \right.$ | (9) |

式中,B为车辆的轴距;a、b为控制参数;

| $\left\{ {\begin{array}{*{20}{c}} {a\left( k \right) = \bar a\left( k \right)\left( {1 + {\delta _p}} \right) + {\delta _a}}\\ {b\left( k \right) = \bar b\left( k \right)\left( {1 + {\delta _s}} \right) + {\delta _b}} \end{array}} \right.$ | (10) |

式中,δa、δb为干扰噪声;δp、δs为相乘噪声,其反映了当车辆的速度与转向角发生变化时,车辆行为的不确定性增加。δa、δb、δp、δs相互独立,都为均值为零、协方差已知的高斯白噪声。

毫米波雷达的测量结果为前车与雷达的相对距离ρ、相对速度

| $\begin{array}{l} \left[ {\begin{array}{*{20}{c}} {\rho \left( k \right)}\\ {\dot \rho \left( k \right)}\\ {\theta \left( k \right)} \end{array}} \right] = \left[ {\begin{array}{*{20}{c}} {\sqrt {{x_r}^2\left( k \right) + {y_r}^2\left( k \right)} }\\ {\frac{{{x_r}\left( k \right)v\left( k \right){\rm{cos}}\theta + {y_r}\left( k \right)v\left( k \right){\rm{sin}}\theta }}{{\sqrt {{x_r}^2\left( k \right) + {y_r}^2\left( k \right)} }}}\\ {{\rm{arctan}}\left( {{y_r}\left( k \right)/{x_r}\left( k \right)} \right)} \end{array}} \right] + \\ \;\;\;\;\;\;\;\;\;\;\;\;\;\;\;{\left[ {\begin{array}{*{20}{c}} {{v_\rho }}&{{v_{\dot \rho }}}&{{v_\theta }} \end{array}} \right]^T} \end{array}$ | (11) |

式中,雷达测量噪声

为实现雷达与视觉目标跟踪数据的融合,本文在增加少量计算的前提下,采用归一化互相关系数对其滤波结果进行加权:

| $ \left\{ \begin{array}{l} \hat r\left( k \right) = \frac{{{\rho _{{\rm{KCF}}}}{{\hat r}_{{\rm{KCF}}}}\left( k \right) + {\rho _{{\rm{EKF}}}}{{\hat r}_{{\rm{EKF}}}}\left( k \right)}}{{{\rho _{{\rm{KCF}}}} + {\rho _{{\rm{EKF}}}}}}\\ \rho = \frac{{\sum\limits_{j = 1} ^M \sum\limits_{k = 1} ^N \left( {{f_{j, k}} - \bar f} \right)\left( {{g_{j, k}} - \bar g} \right)}}{{\sqrt {\sum\limits_{j = 1} ^M \sum\limits_{k = 1} ^N {{({f_{j, k}} - \bar f)}^2}} \sqrt {\sum\limits_{j = 1} ^M \sum\limits_{k = 1} ^N {{({g_{j, k}} - \bar g)}^2}} }}\\ \bar f = \frac{1}{{MN}}\sum\limits_{j = 1} ^M \sum\limits_{k = 1} ^N {f_{j, k}}, \bar g = \frac{1}{{MN}}\sum\limits_{j = 1} ^M \sum\limits_{k = 1} ^N {g_{j, k}} \end{array} \right. $ | (12) |

式中,

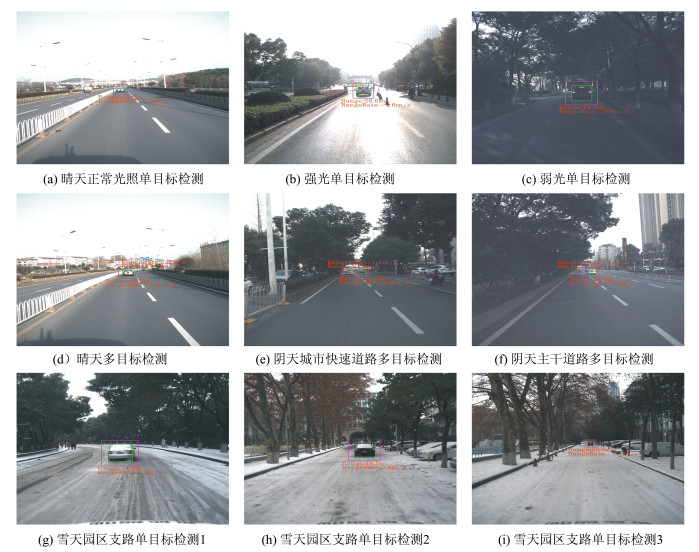

为验证本文方法的有效性与鲁棒性,在武汉市快速道路、主干道路、园区支路等交通环境下,以及晴天(正常、强光、弱光)、阴天、雪天等不同天气条件下进行了实车测试。实验采用的毫米波雷达型号为Delphi ESR(electronic scanning radar),工作频率为20 Hz,视觉传感器型号为PointGrey Blackfly S USB3.0,采集分辨率为2 048×2 048像素,RGB模式下帧频率为25帧/s。计算设备采用工业控制计算机,处理器型号为Intel Core i5,内存大小为8 GB。算法采用C++语言实现,在上述硬件平台下平均耗时为23 ms,满足实时计算要求。实车测试平台如图 5所示,实验结果如图 6所示。检测统计数据如表 1、表 2所示,其中车辆数目计算方式为每帧图像车辆数目的总和,正确检测数目计算方式为算法识别出车辆总和,误检数目计算方式为算法检测出的非车辆目标总和。图 6中Range为前车与主车的相对距离,RangeRate为前车与主车的相对速度。

|

| 图 5 实车测试平台,自动驾驶汽车“途联号” Fig. 5 Experiment Platform, an UGV Named "Tulian" |

|

| 图 6 不同道路环境与天气状况下的检测结果 Fig. 6 Vehicle Detection Results on Different Traffic Environments and Various Weather Conditions |

| 序号 | 道路环境 | 天气状况 | 车辆数目 | 正确检测 | 误检 | 准确率/% | 误检率/% |

| 视频1 | 快速道路 | 晴天(正常) | 854 | 799 | 25 | 93.56 | 2.93 |

| 视频2 | 园区支路 | 晴天(强光) | 505 | 440 | 21 | 87.13 | 4.16 |

| 视频3 | 园区支路 | 晴天(弱光) | 497 | 428 | 31 | 86.12 | 6.24 |

| 视频4 | 主干道路 | 阴天 | 766 | 705 | 26 | 92.04 | 3.39 |

| 视频5 | 园区支路 | 雪天 | 449 | 408 | 16 | 90.87 | 3.56 |

| 合计 | 3 071 | 2 780 | 119 | 90.52 | 3.87 |

| 序号 | 道路环境 | 天气状况 | 车辆数目 | 正确检测 | 误检 | 准确率/% | 误检率/% |

| 视频1 | 快速道路 | 晴天(正常) | 854 | 745 | 64 | 87.23 | 7.47 |

| 视频2 | 园区支路 | 晴天(强光) | 505 | 385 | 67 | 76.23 | 13.33 |

| 视频3 | 园区支路 | 晴天(弱光) | 497 | 384 | 79 | 77.34 | 15.87 |

| 视频4 | 主干道路 | 阴天 | 766 | 634 | 76 | 82.77 | 9.89 |

| 视频5 | 园区支路 | 雪天 | 449 | 370 | 45 | 82.43 | 10.12 |

| 合计 | 3 071 | 2 518 | 331 | 82.01 | 10.78 |

对检测统计结果进行分析,文献[17]采用对称性特征进行车辆检测,准确性受目标边缘提取效果影响较大,在强光与弱光等恶劣光照条件下准确性较低。此外,其未对毫米波雷达数据进行有效预处理,导致了车辆假设存在ROI生成数目过多,造成了算法较高的误检率。本文改进方法则对雷达原始数据进行了噪声过滤,剔除了大量无效雷达目标,降低了雷达误检对算法的影响并降低了计算耗时。其次,通过利用目标景深信息,提高了车底阴影检测的准确性,有效排除了显著非车辆目标。通过对重生成的准确车辆ROI采用具有光照、阴影良好不变性的HOG特征结合SVM分类器的方法进行再次检验,大幅度降低了环境对算法的影响,提高了检测的精确性,降低了误检率。最后,通过分别对雷达目标与视觉目标进行跟踪并对其结果进行融合,使系统在弱光、强光和阴影等环境突变情况下过渡平滑,并且较好地抑制了传感器配准误差对于远距离目标检测和上下坡目标检测的影响,减少了漏检与误检情况的发生,提升了检测的稳定性与鲁棒性。

6 结语近年来,自动驾驶技术发展空前繁荣,在世界范围内受到广泛的关注,自动驾驶技术致力于为人类提供便捷智能的出行方案[26]。城市交通场景下的动态目标检测与跟踪对于自动驾驶技术的研究至关重要,高智能化的驾驶决策(如避障、超车、跟车等)都依赖于对运动目标的识别与跟踪[27]。融合毫米波雷达与机器视觉的车辆检测方法是实现自动驾驶环境感知技术的重要手段,本文对现有融合毫米波雷达与视觉的车辆检测方法进行了改进。针对目标检测,提出一种基于层次聚类的雷达滤波方法,可有效提取雷达运动目标,提升雷达数据质量。针对目标跟踪,提出一种基于KCF-EKF的目标跟踪方法,通过分别跟踪雷达目标与图像目标再进行融合的策略,对车辆几何与运动信息进行了有效估计,提高了智能驾驶前方车辆信息感知的准确性。将实车测试结果与现有方法进行对比,数据表明,本文算法在不同道路环境中与各类恶劣天气条件下均能表现出良好的准确性与鲁棒性,算法的有效检测距离超过100 m,充分体现了毫米波雷达与视觉结合在目标检测方面的优势。在后续工作中,将结合地图信息,一方面解决弯道场景下毫米波雷达误检率较高的问题,另一方面解决在上下坡等特殊场景中因未对传感器姿态做补偿而造成的误检与漏检的问题。此外,将进一步扩大目标检测的范围与检测的类别数目。

| [1] |

Wang G, Xiao D, Gu J. Review on Vehicle Detection Based on Video for Traffic Surveillance[C]. IEEE International Conference on Automation and Logistics, Qingdao, China, 2008 https://ieeexplore.ieee.org/document/4636684/

|

| [2] |

Sun Z, Bebis G, Miller R. On-road Vehicle Detection: A Review[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2006, 28(5): 694-711. DOI:10.1109/TPAMI.2006.104 |

| [3] |

Guo Lei, Li Keqiang, Wang Jianqiang, et al. A Feature-Based Vehicle Detection Method[J]. Automotive Engineering, 2006, 28(11): 1031-1035. (郭磊, 李克强, 王建强, 等. 一种基于特征的车辆检测方法[J]. 汽车工程, 2006, 28(11): 1031-1035. DOI:10.3321/j.issn:1000-680X.2006.11.017 ) |

| [4] |

Hoffmann C. Fusing Multiple 2D Visual Features for Vehicle Detection[C].IEEE Intelligent Vehicles Symposium, Meguro-Ku, Japan, 2006 https://ieeexplore.ieee.org/document/1689662/

|

| [5] |

Wang Wenlong, Tang Luliang, Li Qingquan, et al. Vehicle Detection Algorithm with Video from Airborne Camera[J]. Geomatics and Information Science of Wuhan University, 2010, 35(7): 786-779. (王文龙, 唐炉亮, 李清泉, 等. 一种利用飞艇航拍视频的运动车辆检测方法[J]. 武汉大学学报·信息科学版, 2010, 35(7): 786-779. ) |

| [6] |

Liu Hui, Li Qingquan, Gao Chunxian, et al. Moving Target Detection Using C_SURF Registration[J]. Geomatics and Information Science of Wuhan University, 2014, 39(8): 951-955. (刘慧, 李清泉, 高春仙, 等. 利用C_SURF配准的空基视频运动目标检测[J]. 武汉大学学报·信息科学版, 2014, 39(8): 951-955. ) |

| [7] |

Tan F, Li L, Cai B, et al. Shape Template Based Side-View Car Detection Algorithm[C]. IEEE International Workshop on Intelligent Systems and Applications, Wuhan, China, 2011 https://ieeexplore.ieee.org/document/5873380

|

| [8] |

Liu Cao, Zheng Hong, Li Xi, et al. A Method of Moving Vehicle Detection in All-weather Based on Melted Multi-channel HOG Feature[J]. Geomatics and Information Science of Wuhan University, 2015, 40(8): 1048-1053. (刘操, 郑宏, 黎曦, 等. 基于多通道融合HOG特征的全天候运动车辆检测方法[J]. 武汉大学学报·信息科学版, 2015, 40(8): 1048-1053. ) |

| [9] |

Guzman S, Gomez A, Diez G, et al. Car Detection Methodology in Outdoor Environment Based on Histogram of Oriented Gradient (HOG) and Support Vector Machine (SVM)[C].Networked and Electronic Media, Valparaiso, Chile, 2017

|

| [10] |

Harmer S, Bowring N, Andrews D, et al. A Review of Nonimaging Stand-Off Concealed Threat Detection with Millimeter-Wave Radar [Application Notes][J]. IEEE Microwave Magazine, 2012, 13(1): 160-167. |

| [11] |

Liu Zhifeng, Wang Jianqiang, Li Keqiang. Robust Vehicular Radar Target Determination[J]. Journal of Tsinghua University(Natural Science Edition), 2008, 48(5): 875-878. (刘志峰, 王建强, 李克强. 具有鲁棒特性的车载雷达有效目标确定方法[J]. 清华大学学报(自然科学版), 2008, 48(5): 875-878. DOI:10.3321/j.issn:1000-0054.2008.05.029 ) |

| [12] |

Gao Zhenhai, Wang Jun, Tong Jing, et al. Target Motion State Estimation for Vehicle-Borne Millimeter-Wave Radar[J]. Journal of Jilin University (Engineering and Technology Edition), 2014, 44(6): 1537-1544. (高振海, 王竣, 佟静, 等. 车载毫米波雷达对前方目标的运动状态估计[J]. 吉林大学学报(工学版), 2014, 44(6): 1537-1544. ) |

| [13] |

Wu J, Zhang G. A Joint Processing Scheme of the Aerostat-Borne Radar for the Low Altitude Targets Detection in Urban Clutter Environment[C]. IEEE Radar Symposium, Dresden, Germany, 2015

|

| [14] |

Cho H, Seo Y W, Kumar B V K V, et al. A Multi-sensor Fusion System for Moving Object Detection and Tracking in Urban Driving Environments[C]. IEEE International Conference on Robotics and Automation (ICRA), Hong Kong, China, 2014 https://ieeexplore.ieee.org/document/6907100

|

| [15] |

Jin L, Fu M Y, Wang M L, et al. Vehicle Detection Based on Vision and Millimeter Wave Radar[J]. Journal of Infrared & Millimeter Waves, 2014, 33(5): 465-471. |

| [16] |

Wang Baofeng, Qi Zhiquan, Ma Guocheng, et al. Vehicle Detection Based on Information Fusion of Radar and Machine Vision[J]. Automotive Engineering, 2015, 37(6): 674-678, 736. (王宝锋, 齐志权, 马国成, 等. 一种基于雷达和机器视觉信息融合的车辆识别方法[J]. 汽车工程, 2015, 37(6): 674-678, 736. DOI:10.3969/j.issn.1000-680X.2015.06.011 ) |

| [17] |

Wang X, Xu L, Sun H, et al. On-Road Vehicle Detection and Tracking Using MMW Radar and Monovision Fusion[J]. IEEE Transactions on Intelligent Transportation Systems, 2016, 17(7): 2075-2084. DOI:10.1109/TITS.2016.2533542 |

| [18] |

Wang Y, Papageorgiou M. Real-Time Freeway Traffic State Estimation Based on Extended Kalman Filter: A General Approach[J]. Transportation Research Part B, 2005, 39(2): 141-167. DOI:10.1016/j.trb.2004.03.003 |

| [19] |

Henriques J F, Rui C, Martins P, et al. High-speed Tracking with Kernelized Correlation Filters[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 37(3): 583-596. |

| [20] |

Luo Xiao, Yao Yuan, Zhang Jinhuan. Unified Calibration Method for Millimeter-wave Radar and Camera[J]. Journal of Tsinghua University(Natural Science Edition), 2014, 54(3): 289-293. (罗逍, 姚远, 张金换. 一种毫米波雷达和摄像头联合标定方法[J]. 清华大学学报(自然科学版), 2014, 54(3): 289-293. ) |

| [21] |

Zhang Z. A Flexible New Technique for Camera Calibration[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2000, 22(11): 1330-1334. DOI:10.1109/34.888718 |

| [22] |

Huang M, Yu W, Zhu D. An Improved Image Segmentation Algorithm Based on the Otsu Method[C].IEEE 13th ACIS International Conference on Software Engineering, Artificial Intelligence, Networking and Parallel & Distributed Computing (SNPD), Kyoto, Japan, 2012

|

| [23] |

Qi Meibin, Pan Yan, Zhang Yinxia. Preceding Moving Vehicle Detection Based on Shadow of Chassis[J]. Journal of Electronic Measurement & Instrument, 2012, 26(1): 54-59. (齐美彬, 潘燕, 张银霞. 基于车底阴影的前方运动车辆检测[J]. 电子测量与仪器学报, 2012, 26(1): 54-59. ) |

| [24] |

Danelljan M, Hager G, Khan F S, et al. Discriminative Scale Space Tracking[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2016, 39(8): 1561-1575. |

| [25] |

Boltes M, Seyfried A, Steffen B, et al. Automatic Extraction of Pedestrian Trajectories from Video Recordings[M]. Berlin, Heidelberg: Springer, 2010: 43-54.

|

| [26] |

Li Deyi, Zhao Fei, Liu Meng, et al. Difficulty Analysis and Prospect of Autonomous Vehicle Mass Production[J]. Geomatics and Information Science of Wuhan University, 2018, 43(12): 22-26. (李德毅, 赵菲, 刘萌, 等. 自动驾驶量产的难点分析及展望[J]. 武汉大学学报·信息科学版, 2018, 43(12): 22-26. ) |

| [27] |

Ye Yutong, Li Bijun, Fu Liming. Fast Object Detection and Tracking in Laser Data for Autonomous Driving[J]. Geomatics and Information Science of Wuhan University, 2019, 44(1): 142-147, 155. (叶语同, 李必军, 付黎明. 智能驾驶中点云目标快速检测与跟踪[J]. 武汉大学学报·信息科学版, 2019, 44(1): 142-147, 155. ) |

2019, Vol. 44

2019, Vol. 44