文章信息

- 张兴国, 刘学军, 王思宁, 刘洋

- ZHANG Xingguo, LIU Xuejun, WANG Sining, LIU Yang

- 监控视频与2D地理空间数据互映射

- Mutual Mapping Between Surveillance Video and 2D Geospatial Data

- 武汉大学学报·信息科学版, 2015, 40(8): 1130-1136

- Geomatics and Information Science of Wuhan University, 2015, 40(8): 1130-1136

- http://dx.doi.org/10.13203/j.whugis20130817

-

文章历史

- 收稿日期: 2013-12-23

2. 南京师范大学虚拟地理环境教育部重点实验室, 江苏 南京, 210023

2. Key Laboratory of Virtual Geographic Environment, Nanjing Normal University, Ministry of Education, Nanjing 210023, China

目前,由于缺乏有效安保而造成的交通事故、偷盗、打架斗殴、非法污染物排放等屡见不鲜,政府和各级管理部门逐步加大了对视频监控技术的应用,监控探头已遍及城市的各重要区域。实时监控区域状态,可为地理环境监测,突发事件预警及处理等提供有力支撑。目前,对于监控区域内的监控视频,常采用"井"字窗格、各自独立的视图方式。对于区域状态的了解,需要预先了解各摄像机的方位、监控区域的地理信息,并结合所观察的监控视频理解区域的实时状态。而地理信息具有可定位、可量测、一览性等优势,如果将各个监控视频中暗含的时空信息映射至地理空间,则可通过GIS软件查看区域的实时状态,也可将空间分析方法应用到视频分析中,有助于降低视频理解的难度。同时,相对于传统的地理空间数据,监控视频具有真实、高清、实时的优势,将其融入地理空间数据中,可提高地理空间数据的空间分辨率和现势性。地理空间数据中2D地理空间数据使用最为广泛。本文重点研究监控视频与2D地理空间数据的互映射,所构建的模型及方法以实际应用需求为导向,主要面向大范围、监控视频众多的视频监控系统,如警用GIS (PGIS)等。

对于视频监控系统与2D GIS的集成,国内外学者基于不同的应用目的,提出了多种监控视频与2D地理空间数据的融合方法,主要包括:(1)监控视频在地图中的示意化表达。在地图中将摄像机中心表示为一个点要素或者将摄像机所监控的地面区域以一个扇形要素来表示[1, 2]。该方法虽然实现了摄像机位置和监控区域在2D地图中的表达,但以示意为主,不准确,也不能实现监控视频图像坐标与2D平面直角坐标的精确映射。(2)基于单点定位与多点定位的方法对单一观测点进行定位[3]。(3)基于2D单应的方法。在监控视频和高清遥感影像中选取相应的点位,计算单应矩阵,实现监控视频图像坐标到2D平面直角坐标的转换[4, 5, 6, 7, 8]。该方法以高清遥感影像或者大比例尺地图数据为基础,需要交互选点,也需要考虑点位的分布,比较繁琐,适合固定摄像机的映射需求,无法在具有云台功能的摄像机中使用。(4)基于几何关系的映射方法。通常摄像机的旋转角很小时,则可以将某一平面与视锥体相交,求解交点的坐标,构成一个多边形,即当前摄像机在2D地图中的视域[9]。该方法需要地面水平,摄像机旋转角为0。如果要实现图像坐标与平面直角坐标的映射,则需要基于视域多边形与相应的图像坐标计算单应矩阵[10]。

从理论上讲,监控视频的成像过程遵循相机模型,即监控视野内任一点位的三维空间直角坐标均可投射到像平面上。而相反地,像平面上的任一点却不能映射至三维空间中。如何实现两者的互映射,既满足理论的严密性,又能少交互、应用便捷、兼顾固定摄像机和具有云台的摄像机,是本文研究的重点。对于大范围内存在大量监控视频的情况,传统的基于控制点求解2D单应的方法比较繁琐。例如一个城市的警用GIS,其监控视频众多,对每一个监控视频可能需要一个或多个2D单应矩阵的求解,对人员技术要求较高,并且对于PTZ监控视频,该方法根本无法使用。因此,必须从相机模型本身出发,构建物理意义明确且适合固定摄像机,同时具有云台功能的摄像机,才能够实现监控视频与2D地理空间数据互映射的模型和方法。同时,也必须重视地理信息科学领域对监控视频在数据获取、表达和应用方面的需求。

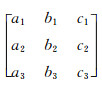

1 监控视频与2D地理空间数据互映射模型 1.1 相机模型相机模型是对成像过程的建模,摄影测量学和计算机视觉分别构建了面向本领域的数学模型。前者模型参数明确,后者模型参数隐藏。相机模型表达了物点、相点和针孔共线的几何关系,其中,针孔模型(pin-hole modal)最为简单。为了构建物理意义明确、适合于监控视频与2D地理空间数据融合的互映射模型,需要对两个相机模型进行对比分析。

(1)摄影测量学相机模型

在摄影测量学中,多采用量测型相机。为了保障测绘产品的精度,相机需严格检校。其相机模型中摄像机内外参是显式的,其摄像机模型即共线方程,如式(1)[11]。

式中,(X,Y,Z)为物方空间坐标;(Xs,Ys,Zs)为摄像机中心坐标;(x,y)为像平面坐标;(x0,y0)为像主点坐标;f为主距; 为三个角元素构成的旋转矩阵。

为三个角元素构成的旋转矩阵。

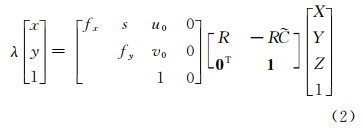

(2)计算机视觉相机模型

在计算机视觉中,常采用普通相机,相机参数通常未知,主要通过相机标定/自标定来获取,其相机模型以齐次方程[12]来表示:

式中,(X,Y,Z)为世界坐标; 表示摄像机中心在世界坐标系中的坐标;(x,y)为像平面坐标;(u0,v0)是以像素为单位的像主点坐标;fx=f/px,fy=f/py是以像素宽度(px)和高度(py)表示的等效焦距;s表示影像坐标轴的非正交性;R表示旋转变换。

表示摄像机中心在世界坐标系中的坐标;(x,y)为像平面坐标;(u0,v0)是以像素为单位的像主点坐标;fx=f/px,fy=f/py是以像素宽度(px)和高度(py)表示的等效焦距;s表示影像坐标轴的非正交性;R表示旋转变换。

对于某一监控视频而言,内外参是确定的。但因两个领域相关坐标系定义的差异性,导致两个模型中部分内外参的数值不同。为了便于将计算机视觉中的相关研究成果集成到GIS中,可以将摄影测量学的相机模型中的内外参数代入计算机视觉的相机模型:

式中,f,u0=x0ph;v0=Hpic-y0ph;x0ph为摄影测量像主点横坐标,y0ph为摄影测量像主点纵坐标,Hpic为图像高度均以像素为单位。

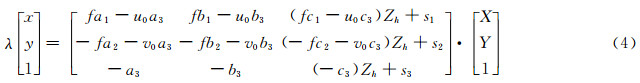

1.2 多平面约束的几何互映射模型监控视频与2D地理空间数据的几何互映射旨在实现监控视频的图像坐标和2D平面直角坐标的相互转换。根据相机模型,三维空间直角坐标可以转换为图像坐标,但2D地理空间数据仅仅具备平面直角坐标,缺乏高度坐标(Z),因此不能将2D平面直角坐标映射至监控视频中。监控视频在成像过程中丢失了三维信息,其图像坐标也不能转换为三维空间直角坐标或平面直角坐标。基于该分析,本文引入约束条件,构建基于多平面约束的几何互映射模型。

当前,视频监控在城市管理、道路交通中最为常用,单一监控视频相应的监控区域范围小、场景简单,通常可将地面区域近似为一个或多个平面。基于此,可将区域中各平面赋予相应的高度值,即2D地理空间数据拥有了一个或多个Z坐标,则监控视频中的地面区域与相应的2D地理空间数据可实现坐标的相互转换,即多平面约束的几何互映射。将式(3)中的Z改为Zh,Zh为监控区域中某平面的高度值,经过各个矩阵的运算,整理后如式(4)。

式中,s1=(fa1-u0a3)(-Xs)+(fb1-u0b3)\5 (-Ys) +(fc1-u0c3)(-Zs);s2=(-fa2-v0a3) (-Xs)+(-fb2-v0b3)(-Ys)+(-fc2-v0c3) (-Zs);s3=(-a3)(-Xs)+(-b3)(-Ys)+ (-c3)(-Zs)。

因此,Zh平面约束的几何互映射模型的实质为二维坐标转换,变换矩阵(H)是可逆的。平面直角坐标经H可转换为图像坐标。相反地,图像坐标经H的逆矩阵也可以转换为平面直角坐标。视频监控区域可能存在多个平面,则相应就有多个变换矩阵,如H 1,H 2… H n。当n较多时,2D地理空间数据已近似于三维地理空间数据了,可直接采用三维地理空间数据与监控视频的互映射方法。

1.3 内容互映射模型监控视频主要由背景和前景构成,背景为高清的图像,前景为实时的动态目标,两者都是非常宝贵的数据资源。同样,2D地理空间数据具有明确的空间参考和属性信息,也是视频分析中重要的信息。

基于监控视频与2D地理空间数据的几何互映射模型,设计了两者的内容互映射模型,旨在实现两者数据的共享、达到相互增强的目的,包括两大部分:

1)监控视频到2D地理空间数据的映射

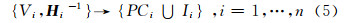

监控视频到2D地理空间数据的内容映射是基于几何互映射模型,将监控视频中的一个或几个平面区域内的前景和背景数据转换为2D地理空间数据的过程。监控视频中常见的平面区域主要包括路面、广场、草地等。该内容映射模型的形式化表达如式(5)。

式中,Vi为监控视频;H i-1为H i的逆矩阵;PCi为具有颜色信息的三维点云和前景目标点要素;Ii为具备空间参考的图像。

对于每一监控视频,基于其几何互映射模型,可将图像坐标转换为平面直角坐标,然后获取相应的平面区域的颜色信息和动态目标的位置信息,即该内容映射结果为具有颜色信息的点云文件和动态目标点位置文件。亦可将监控视频中的平面区域映射为拥有平面直角坐标的栅格图像。对于众多监控视频,部分监控视频具有重叠区域,需要对映射结果进行合并或融合处理。

2)2D地理空间数据到监控视频的映射

2D地理空间数据到监控视频的映射是以几何互映射为基础,将2D地理空间数据映射至监控视频中,使得监控视频可定位,可量测,属性明确。

式中,Di为2D地理空间数据;H i为几何互映射矩阵;IIi为叠加地理空间数据的视频图像;IVi为视频图像和矢量数据的集合。

监控区域中的任一摄像机,都具有明确的视域,基于几何互映射矩阵,可将该范围中的2D地理空间数据映射到监控视频中。内容映射的结果,可采用两种方式,即IIi和IVi。IIi是在原始视频上叠加映射后的2D地理空间数据。IVi是保留原始视频信息,额外生成一个附件,其中包含映射后的图形和属性信息。

1.4 模型应用1)模型应用方法

互映射模型中,各个参数物理意义明确,只要获取了相关参数即可使用。相关参数的获取可通过实测、标定等方法得到。但对于互映射精度要求不高的情况,本文提出了如下的应用方法,可满足多数视频监控系统与2D GIS的集成需求,详述如下。

(1)接入监控视频

通过硬件厂商提供的视频访问API,在2D GIS系统中接入各个摄像机相应的监控视频。

(2)获取摄像机内外参数

在2D GIS中指定摄像机中心的位置,包括平面坐标X和Y,其相对于地面的高度可以实测或估计,则得到摄像机中心点的三维坐标(XS,YS,ZS)。对于摄像机的方位角和倾角,可通过摄像机中心点的坐标、视频图像中心点在地图中的坐标(Xt,Yt)及所在平面的高度Zt进行求解。在应用中,摄像机的旋转角通常可默认为0。而获取摄像机的内参数关键是摄像机的主距,在结构化场景中,可以通过2个或者3个灭点来计算。非结构化场景中,可预先标定或从摄像机硬件参数中获取。

(3)监控区域多平面划分及互映射

首先,将监控的区域划分为多个平面并赋予相应的相对高度。然后,对于不同相对高度的平面,计算其变换矩阵。最后,可将监控视频每个点位映射至2D地图中,也可将任一2D地理要素映射至监控视频中。

2)单一平面约束的互映射

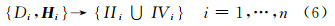

假设摄像机的视域为一个平面,以拍摄的某一视频进行验证。该摄像机的内外参数:视频图像的宽和高分别为800和600像素,主距785像素,像主点为视频图像的中心,摄像机中心点坐标(680 263.57,3 555 013.36) m,高度为13 m,倾角56°,方位角179°,地平面的高度为0 m。地理空间数据采用WGS 1984 UTM 50N平面直角坐标系,包括QuickBird遥感影像和DLG数据。图 1(a)是将监控视频映射为栅格类型的2D影像,图 1(b)是将2D DLG映射到监控视频中。

|

| 图 1 单一平面约束下监控视频与2D地理空间数据的互映射 Fig. 1 Mutual Mapping Between Surveillance Video and 2D Geospatial Data Under the Constrain of the Single Plane |

3)多平面约束的互映射

多平面约束的互映射是将监控区域近似为2个及以上的平面,则监控视频与2D地理空间数据的互映射需要基于相应区域的变换矩阵进行互映射。这里以拍摄的某一视频为例进行验证,该摄像机的内外参数:视频图像宽和高分别为800和600像素,主距785像素,像主点为视频图像中心,摄像机中心点坐标(680 285.30,3 555 011.14) m,相对于地平面高度为13 m,倾角69.27°,方位角209.33°。地图采用WGS 1984 UTM 50N平面直角坐标系,核心区域平面高度为0 m,而右上侧的平面高度为1.86 m。图 2(a)是2D DLG分别按照0 m和1.86 m两个平面约束下的变换矩阵映射的结果,图 2(b)为0 m图像区域逐像素点映射后的结果。

|

| 图 2 多平面约束下监控视频与2D地理空间互映射 Fig. 2 Mutual Mapping Between Surveillance Video and 2D Geospatial Data Under the Constrain of Multiple Planes |

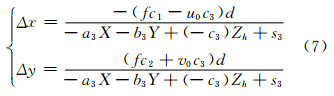

较高点位的视频监控设备,具有更广的视域。当地面起伏不大或者相对于摄像机的高度而言可忽略时,可使用单一平面约束的互映射模型。平面高度的精确性对于互映射有较大影响。假如平面高度存在偏差d,则平面直角坐标映射后的图像坐标就会出现偏差,如式(7),反之亦然。

因平面高度的偏差致使低于约束平面高程的区域实际映射偏差趋于远方,而高于约束平面高程的区域实际映射偏差趋于近处,即具有"低远高近"的映射特征。这里以拍摄的某一视频图像进行验证,摄像机的内外参数:视频图像宽和高分别为800和600像素,主距785像素,像主点为视频图像中心,摄像机中心点坐标(680 263.67,3 555 011.14) m,相对于地平面高度为24.09 m,倾角70.50°,方位角177.00°。地图采用WGS 1984 UTM 50N平面直角坐标系,核心区域平面高度为0 m,而右上侧的平面高度为1.86 m,正前方半圆形的区域高度为-3.61 m。图 3(a)中红色线代表依据正确高程的平面映射,蓝色线为高程为0 m的平面约束下的映射。很明显,如果采用0 m高程的平面约束,大于0 m的区域映射后靠近摄像机,而小于0 m的区域映射后远离摄像机。相反,将监控视频映射至地图中,则呈现"低近高远"的映射特征,图 3(b)中蓝色线为地面起伏所造成的影响。

|

| 图 3 地面起伏对映射结果的影响 Fig. 3 Impact of Terrain Undulations on the Mapping Result |

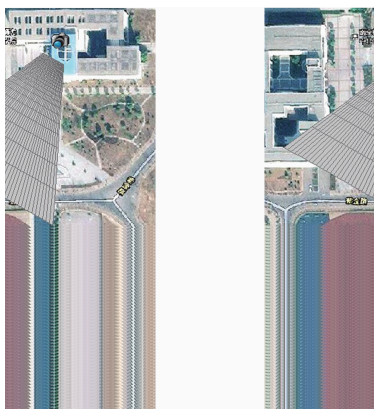

对于图像中任一点p (i,j),假设像素为正方形,则以p为中心的正方形的4个角点坐标分别为p1(i-0.5,j-0.5),p2(i+0.5,j-0.5),p3(i+0.5,j+0.5),p4(i-0.5,j+0.5)。根据平面约束的几何互映射模型,可以得到4个点对应的空间直角坐标p1,p2,p3,p4构成一个四边形。定义四边形的面积为该像素的空间分辨率,在距离摄像机较近的区域,四边形面积较小,具有较高的空间分辨率,相反,远处的区域具有较低的空间分辨率。空间分辨率在空间上的分布,示意图如图 4,其中,每个多边形由p1(i-5,j-5),p2(i+5,j-5),p3(i+0.5,j+5),p4(i-5,j+5)四个点构成。图 4显示,每个像素点在平面空间上对应于一个四边形,其中上下边平行,呈条带状。

|

| 图 4 平面约束下监控视频空间分辨率 Fig. 4 Spatial Resolution of Surveillance Video Under the Constrains of the Single or Multiple Planes |

多平面约束的监控视频与2D地理空间数据的互映射模型主要面向结构化的地理场景,通常可抽象为多个不同高度的平面,如道路、停车场、运动场地等。当前,视频监控的场景通常范围较小、地面区域为主、映射精度要求不高,所研究的模型及应用方法可以满足当前的应用需求。对于非结构化地理场景,难以抽象为多个平面,如山坡、复杂的建筑物、雕塑等,通过单一监控视频也无法获取三维信息,本模型难以满足其要求。可通过具有一定重叠度的两个及以上的监控视频或者移动视频来获取三维信息,将其融入3D GIS中。相反,也可以3D GIS中的三维信息赋予监控视频,为智能视频分析提供地理信息支持。

本文仅对监控视频与2D地理空间数据互映射模型、方法及应用进行了研究,而相关的模型参数的自动/半自动计算、映射质量评价、智能化和自动化的互映射等问题尚未解决,需要进一步研究。

| [1] | Kong Yunfeng. Design of GeoVideo Data Model and Implementation of Web-based Video GIS[J]. Geomatics and Information Science of Wuhan University, 2010, 35(2): 133-137(孔云峰. 地理视频数据模型设计及网络视频GIS实现[J]. 武汉大学学报·信息科学版,2010,35(2):133-137) |

| [2] | Han Zhigang, Zeng Ming, Kong Yunfeng. Design and Implementation of the Campus Geovideo Monitoring WebGIS System[J]. Science of Surveying and Mapping,2012,37(1):195-197(韩志刚,曾明,孔云峰.校园地理视频监控WebGIS系统设计与实现[J]. 测绘科学, 2012,37(1):195-197) |

| [3] | Wang Yuanyuan. Research on Automatic Positioning Techniques for Forest Fire Video Monitoring System Based on GIS [D]. Beijing: Beijing Forestry University, 2008(王元园. 基于GIS的森林火灾视频监控自动定位技术研究[D].北京:北京林业大学,2008) |

| [4] | Bradshaw K J, Reid I D, Murray D W, et al. The Active Recovery of 3D Motion Trajectories and Their Use in Prediction [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,1997, 19(3): 219-234 |

| [5] | Coifman B, Beymer D, McLauchlan P, et al. A Real-time Computer Vision System for Vehicle Tracking and Traffic Surveillance [J]. Transportation Research Part C: Emerging Technologies, 1998, 6(4): 271-288 |

| [6] | Kim K, Oh S, Lee J, et al. Augmenting Aerial Earth Maps with Dynamic Information[C]. The 8th IEEE International Symposium on Mixed and Augmented Reality, Rlando, USA, 2009 |

| [7] | Song Hongquan, Liu Xuejun, Lv Guonian, et al. Real-time Monitoring for the Regional Crowds Status [J]. Journal of Geo-information Science, 2012, 14(6): 686-692,697(宋宏权,刘学军,闾国年,等. 区域人群状态的实时感知监控[J]. 地球信息科学学报,2012,14(6):686-692,697) |

| [8] | Liu Yawen,Zhang Zuxun,Zhang Jianqing. A New Method for Building Reconstruction Based on Vector Map and Non-metric Camera Image[J]. Geomatics and Informaiton Science of Wuhan University,2005, 30(2): 146-149(刘亚文,张祖勋,张剑清. 利用地图与单影像进行建筑物三维重建的新途径[J]. 武汉大学学报·信息科学版, 2005, 30(2): 146-149) |

| [9] | Jiang Weixing. Design and Implementation of Development Platform for Video Surveillance[D]. Hangzhou: Zhejiang University,2008(蒋卫星.视频监控开发平台的设计与实现[D].杭州:浙江大学,2008) |

| [10] | Zhang Xingguo, Liu Xuejun, Song Hongquan. Video Surveillance GIS: A Novel Application[C]. Geoinfomatics 2013, Kaifeng, China, 2013 |

| [11] | Zhang Zuxun. Digital Photogrammetry and Computer Vision[J]. Geomatics and Informaiton Science of Wuhan University, 2004, 29(12): 1 035-1 039,1 105(张祖勋.数字摄影测量与计算机视觉[J]. 武汉大学学报·信息科学版,2004,29(12):1 035-1 039,1 105). |

| [12] | Zhang Yongjun. Vision Detecting Theory and Methods Based on the Image Sequences[M]. Wuhan:Wuhan University Press,2008:21-23(张永军.基于序列图像的视觉检测理论与方法[M].武汉:武汉大学出版社,2008:21-23) |

2015, Vol. 40

2015, Vol. 40